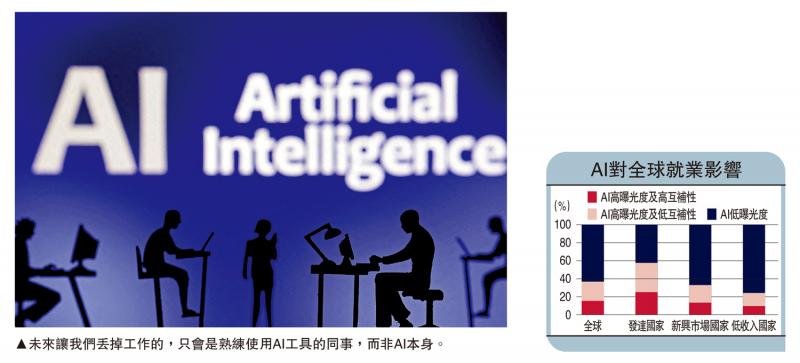

图:未来让我们丢掉工作的,只会是熟练使用AI工具的同事,而非AI本身。

春节期间,文生视频AI工具Sora横空出世,赢得一片赞美之声,更被业界推崇为“世界模拟器”(World Simulator),即可准确展现真实物质的运动规律。但今次笔者撰文“斗胆”预测,文生视频AI距离商用水准仍有不小差距。而在现有GPT技术框架下,本轮AI热潮在经历数年的快速迭代后将遭遇发展瓶颈。

必须要承认,Sora相较文生视频的AI前辈们──Runway、Pika,不仅在时长上实现了突破(Sora长达1分钟,Runway基础视频为4秒、Pika为3秒),并在视频流畅度、光影处理等方面均取得大幅进步。

这也是为什么,每次AI工具迭代都会引发一波“失业恐慌”。就在年初,IMF(国际货币基金组织)还发布报告指出,全球近40%的就业岗位会受到人工智能的影响。

图灵测试与中文房间

不过,笔者要为Sora泼冷水。现行AI技术的底层理论─人工神经网络(Artificial Neural Network),只是通过二进制方式模仿大脑神经的决策流程。也就是说,包括Sora在内的所有AI工具,貌似理解物质世界,但仅是“滥竽充数”。

早在1950年,英国科学家艾伦.图灵就提出一个标准,用来评判机器是否达到人工智能的水平。机器A被关在房间中,与屋外的人类B通过文字交流。如果人类B无法分辨房间内是人类还是机器,则机器A通过了“图灵测试”。

但到了1980年,美国科学家约翰.瑟尔提出了质疑。他描述了这样一种情况:如果一个只懂英语的人被关在屋里,手里拿着一本中英文词典,指导其根据接收到的中文信息选择合适的中文字符来做回答。从屋外的视角来看,这人好像会懂中文,但其实他一窍不通。

局部合理与整体荒谬

那么,如果给机器A一本《物质世界指南》,屋外的人类B很容易产生错判─房间里的机器A好像真的拥有了人工智能。事实上,GPT模型的性质仍属机器智能,依赖于高质量的数据标注与训练。GPT只是记住了如何根据上文来生成下文,并非真的掌握了自然语言。

正是由于“中文房间”效应,我们在使用ChatGPT时,经常遭遇AI出现“幻觉”:捏造内容或者答非所问。这种偏差在文生视频工具中又被放大了,特别是Sora将视频输出延长至1分钟,给了AI更多“犯错”机会。

当我们认真观看Sora的演示视频时会发现,如果只是聚焦单一物体,呈现出的运动效果非常优秀,但如果两个物体之间产生接触,Sora就无法准确模拟出真实的物理规律,如吹灭蜡烛。

这是因为GPT模型只能处理信息的相关性,而无法掌握物理的因果律。受此影响,Sora生成的AI视频“局部合理、整体荒谬”,极大地降低了自身的可靠性及稳定性。这一问题是由技术缺陷所致,靠算力和数据无法从根本上弥补。也因此,未来让我们丢掉工作的,只会是熟练使用AI工具的同事,而非AI本身。

至于外界憧憬的“世界模拟器”,只能等到脑科学实现重大突破的那一天了。