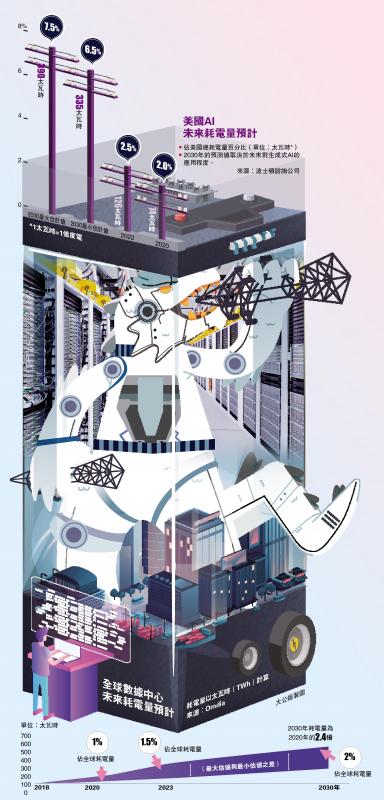

图:美国AI未来耗电量预计。

人工智能(AI)迅猛发展,一个不可避免的问题浮出水面:AI系统运行需要耗费大量的能源,尤其是电力。据估算,OpenAI旗下的聊天机器人ChatGPT,每天消耗超过50万千瓦时的电力,相当一个美国家庭每日耗电量的1.7万倍。以特斯拉创办人马斯克、OpenAI行政总裁阿尔特曼为代表的科技大佬们,纷纷对AI行业所面临的能源危机发出警告,认为“新的能源危机到来”。专家预测,全球AI系统的电力消耗,或将很快相当于欧洲一个中等国家全年发电量。

【大公报讯】AI能力的提升,比拼的是算力,而强大算力的背后就是高耗能。以聊天机器人ChatGPT为例,其进行一次搜寻所需电量,是在谷歌引擎上进行一次搜索所需电量的10倍。据估计,ChatGPT目前每天回应约2亿个请求,消耗超过50万千瓦时的电力。而一个美国家庭平均每天的耗电量为29千瓦时(1千瓦时约为1度电),即ChatGPT日耗电量是每个家庭用电量1.7万倍。

按照目前AI的快速应用趋势,专家预计到2026年,AI消耗的电力将是2023年的10倍。因此,马斯克在2月29日谈及AI时表示,AI芯片短缺的情况可能已经过去,“明年,你会发现没有足够的电力来运行所有的AI芯片”。其实,从去年开始,马斯克多次警告电力短缺问题,并预测美国2年内将爆发大缺电,到2045年美国的电力消耗将增加2倍,如果不尽快行动,将会阻碍AI和电动车发展。

阿尔特曼在1月份瑞士达沃斯会议上也称,未来AI需要能源突破,因为其消耗的电力将远远超出预期。

2027年AI年耗电量可敌国

未来,AI对电力的“胃口”究竟有多大?荷兰阿姆斯特丹自由大学商业与经济学院研究员德弗里斯在去年10月发表论文,预测到2027年AI服务器的年均耗电量,可能相当于荷兰或瑞典等国一个国家一年的总耗电量。

根据美国芯片制造商英伟达公布的数据进行粗略计算,单台英伟达DGX A100服务器的功耗为3至6.5千瓦,相当于数个美国家庭的用电量总和,而多个H100芯片可以在一台服务器上消耗超过10千瓦的电量。德弗里斯表示,英伟达在2023年生产了约10万个H100类型的芯片,到2027年,其年产量或将增至150万个。届时,全球新建的服务器与AI相关的电力消耗,可能会增加85.4至134.0太瓦时(1太瓦时等于1亿度电),该数字与荷兰、阿根廷、瑞典等国家的年用电量相当。英伟达目前拥有数据中心AI专用芯片90%以上的市场份额,其用电量可作为整个AI产业的代表。

德弗里斯的计算,还不包括数据中心用于冷却AI芯片的耗电量,因此AI用电数字可能仍被低估。据国际能源署(IEA)估计,到2026年,全球数据中心、AI和加密货币的耗电量将增加一倍。全球8000个数据中心中约有三分之一位于美国。微软创办人比尔盖茨在上周剑桥能源周会上表示,电力是决定数据中心能否盈利的关键因素,而AI消耗的电力是惊人的。

能源供应恐将捉襟见肘

当下AI行业的龙头OpenAI、Meta、微软等公司完全没有分享耗电相关的信息。这导致AI产业的具体耗电量很难估计,因为不同AI模型的运作方式存在差异,其耗电量也有不一。

近年全球极端天气加剧,高温、极寒、山火和干旱都影响供电。另外,包括美国在内,很多国家的基建设施都面临设备老化等问题,加密货币挖矿热潮、电动车迅速发展在消耗大量的电,如果AI再加入“抢电”战圈,能源供应将更加捉襟见肘。

业界估计,未来五年美国电力需求增长的预测比一年前翻了一番,新的人工智能数据中心、美国《通胀削减法》补贴制造工厂以及拜登政府推动的电动汽车转型,都将使得电力需求激增,这对于美国清洁能源的过渡构成压力。不过,这也可能进一步推动电力投资和转型。阿尔特曼曾称,AI的未来取决于能源方面的突破。科技公司如今已是能源公司的大型投资者。另外,许多科企都正在开发耗电更少的AI模型,即便如此,专家认为当前的业界仍缺乏相关的研发动力,只要行业内对高效模型的激烈竞争不减,全球AI产业对“抢电”的趋势就没有尽头。 (综合报道)